Testen Sie IHR Unternehmen in Minuten

Erstellen Sie Ihr Konto und starten Sie Ihren KI-Chatbot in wenigen Minuten. Vollständig anpassbar, keine Programmierung erforderlich - beginnen Sie sofort, Ihre Kunden zu begeistern!

Einführung: Die sich entwickelnde Landschaft der NLP-Entwicklung

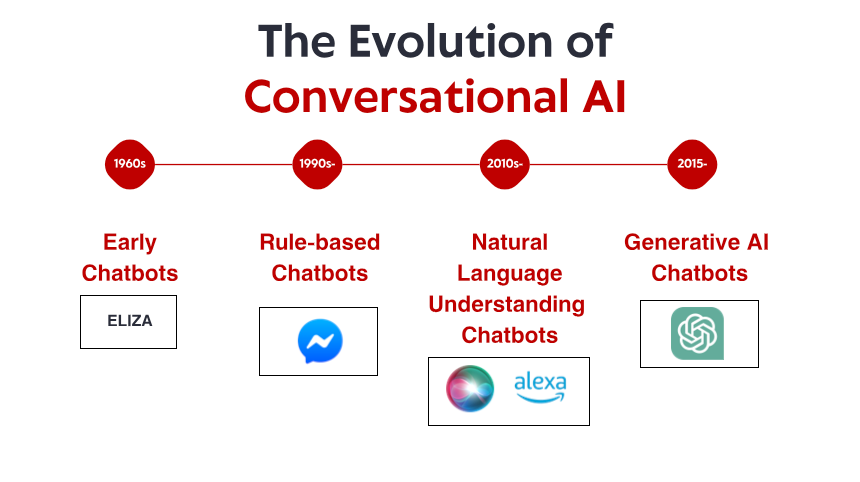

Im vergangenen Jahr wurden in der NLP-Technologie bemerkenswerte Fortschritte erzielt – von effizienteren Feinabstimmungsansätzen bis hin zu multimodalen Funktionen, die Text mit anderen Datentypen verbinden. Laufzeiteffizienz gewinnt zunehmend an Bedeutung, da immer mehr NLP-Workloads auf Edge-Geräte und Consumer-Hardware verlagert werden. Gleichzeitig wurden spezialisierte Domänenfunktionen erweitert, um Branchen vom Gesundheitswesen bis hin zu Rechtsdienstleistungen mit beispielloser Genauigkeit zu bedienen.

Ob Sie einen Konversationsagenten entwickeln, Kundenfeedback analysieren, Erkenntnisse aus Dokumenten gewinnen oder Tools zur Inhaltsgenerierung erstellen – die Wahl der richtigen NLP-Bibliothek kann den Erfolg Ihres Projekts erheblich beeinflussen. Dieser Leitfaden untersucht die sieben wirkungsvollsten NLP-Bibliotheken des Jahres 2025 und vergleicht ihre Stärken, Schwächen und idealen Anwendungsfälle, um Ihnen eine fundierte Entscheidung für Ihr nächstes Entwicklungsprojekt zu ermöglichen.

1. Hugging Face Transformers 6.0: Das umfassende Ökosystem

Wichtige Funktionen und Verbesserungen

Die neueste Version bietet mehrere bahnbrechende Funktionen:

Effizientes Feintuning-Framework: Das neue EFT-Modul reduziert den Rechenaufwand für die Anpassung von Basismodellen an spezifische Aufgaben erheblich. Modelle, die bisher mehrere GPUs zur Feinabstimmung benötigten, können nun mit minimalen Leistungseinbußen auf Consumer-Hardware angepasst werden.

Multimodale Pipelines: Transformers bietet jetzt optimierte Pipelines für die Entwicklung von Anwendungen, die Textanalyse nahtlos mit Bild-, Audio- und sogar Videoanalyse kombinieren – perfekt für die Entwicklung kontextsensitiverer Anwendungen.

Enterprise-Grade-Bereitstellungstools: Das neue Bereitstellungs-Toolkit vereinfacht die Migration von Modellen von der Forschung in die Produktion durch automatisierte Optimierung für verschiedene Hardwareziele, von Serverclustern bis hin zu Mobilgeräten.

Domänenspezialisierungspakete: Vorkonfigurierte Einstellungen und Modelle für spezifische Branchen wie Gesundheitswesen, Recht und Finanzen ermöglichen Entwicklern den Einstieg mit domänenoptimierten Grundlagen statt generischer Modelle.

Warum Entwickler es lieben

Transformers ist weiterhin führend, weil es eine außergewöhnliche Balance zwischen Zugänglichkeit und modernsten Funktionen bietet. Die gut dokumentierte API erleichtert Einsteigern die Implementierung erweiterter NLP-Funktionen, während die umfangreichen Anpassungsmöglichkeiten die Anforderungen erfahrener ML-Ingenieure erfüllen.

Die lebendige Community rund um Hugging Face sorgt zudem dafür, dass Lösungen für häufige Probleme meist nur eine Forumssuche entfernt sind, was die Entwicklungszeit deutlich verkürzt. Mit über 75.000 vortrainierten Modellen im Model Hub finden Entwickler oft spezialisierte Modelle, die genau ihren Anwendungsanforderungen entsprechen, ohne bei Null anfangen zu müssen.

Ideale Anwendungsfälle

Hugging Face Transformers 6.0 eignet sich hervorragend für:

Forschungsprojekte, die schnelles Experimentieren mit verschiedenen Modellarchitekturen erfordern

Produktionsanwendungen, die modernste Sprachkenntnisse erfordern

Teams, die das Wissen und die Ressourcen der Community nutzen möchten

Projekte, die spezialisiertes Fachwissen erfordern (Gesundheitswesen, Recht, Finanzen)

Anwendungen, die multimodale Funktionen benötigen

Hinweise

Obwohl Transformers nach wie vor die vielseitigste Option ist, ist es nicht immer die ressourceneffizienteste Wahl für die Bereitstellung. Einige Entwickler berichten, dass die generalisierte Architektur einen Mehraufwand verursacht, den spezialisierte Bibliotheken vermeiden. Darüber hinaus führt die sich schnell entwickelnde Codebasis gelegentlich zu schwerwiegenden Änderungen zwischen den Hauptversionen.

2. SpaCy 4.0: Produktionsreife Effizienz

Wichtige Funktionen und Verbesserungen

SpaCy 4.0 bietet wesentliche Verbesserungen:

Transformer-Integration: Die aktualisierten Transformer-Pipeline-Komponenten arbeiten jetzt nativ mit den neuesten Modellen und behalten gleichzeitig die effiziente Verarbeitungsarchitektur von SpaCy bei.

Verbesserte Multiprocessing-Funktionalität: Neue Parallelverarbeitungsfunktionen ermöglichen eine nahezu lineare Skalierung für Dokumentverarbeitungsaufgaben und machen SpaCy so für die Stapelverarbeitung riesiger Textsammlungen geeignet.

Erweiterte strukturierte Vorhersage: Neben der Erkennung benannter Entitäten und der Abhängigkeitsanalyse bietet SpaCy jetzt verbesserte Unterstützung für benutzerdefinierte strukturierte Vorhersageaufgaben durch ein flexibleres Annotations- und Trainingsframework.

Schlankere Laufzeitanforderungen: Trotz der erweiterten Funktionen können Kernverarbeitungspipelines nun mit deutlich reduziertem Speicherbedarf ausgeführt werden – entscheidend für den Einsatz in ressourcenbeschränkten Umgebungen.

Verbesserte Regel-Engine: Das Musterabgleichssystem wurde komplett überarbeitet und bietet leistungsfähigere Ausdrücke bei gleichzeitiger Verbesserung der Abgleichgeschwindigkeit um bis zu 300 %.

Warum Entwickler sich dafür entscheiden

SpaCy ist weiterhin die bevorzugte Wahl für Produktionssysteme, da es industrietaugliche Leistung mit einer entwicklerfreundlichen API bietet. Die durchdachte objektorientierte Architektur erleichtert die Integration in größere Anwendungen bei gleichbleibender Leistung.

Das neue Framework „SpaCy Projects“ vereinfacht zudem die Paketierung und Bereitstellung von End-to-End-NLP-Pipelines und ermöglicht es Teams, ihre Entwicklungsabläufe vom Experiment bis zur Produktion zu standardisieren.

Ideale Anwendungsfälle

SpaCy 4.0 eignet sich perfekt für:

Textverarbeitungssysteme mit hohem Durchsatz

Produktionsumgebungen, in denen Zuverlässigkeit und Vorhersagbarkeit entscheidend sind

Anwendungen, die eine industrietaugliche Named-Entity-Erkennung und Relationsextraktion erfordern

Projekte mit Implementierungsbeschränkungen (Speicher, Rechenleistung)

Teams, die sowohl klassische NLP-Funktionen als auch moderne neuronale Ansätze benötigen

Hinweise

Obwohl SpaCy bei der Integration von Transformer-Modellen große Fortschritte erzielt hat, bietet es noch nicht die gleiche Bandbreite an hochmodernen Forschungsimplementierungen wie Hugging Face. Darüber hinaus empfinden einige Entwickler die eigenwillige Architektur als weniger flexibel für hochgradig kundenspezifische Forschungsanwendungen.

3. Cohere SDK: API-First-Sprachintelligenz

Wichtige Funktionen und Verbesserungen

Die Cohere-Plattform bietet mehrere überzeugende Funktionen:

Command- und Command-R-Modelle: Diese Modelle zeichnen sich durch die Befolgung spezifischer Anweisungen und das Verstehen differenzierter Anfragen aus und eignen sich daher ideal für die Entwicklung von Tools, die präzise auf Benutzeranfragen reagieren.

Einbettungsmodelle: Die neueste Generation von Einbettungsmodellen erstellt bemerkenswert genaue semantische Darstellungen und übertrifft bisherige Ansätze bei Abfrage- und Klassifizierungsaufgaben deutlich.

Unternehmensspezifische Anpassung: Für Unternehmen mit spezifischen Anforderungen bietet Cohere jetzt Anpassungsoptionen, mit denen ihre Kernmodelle an spezielle Domänen angepasst werden können, ohne dass umfangreiche Trainingsdatensätze erforderlich sind.

Mehrsprachigkeit: Robuste Funktionen in über 100 Sprachen ermöglichen globale Anwendungen, ohne dass für jede Sprache separate Modelle erforderlich sind.

Verantwortungsvolle KI-Kontrollen: Integrierte Sicherheitsfilter und Bias-Erkennung unterstützen Entwickler bei der Entwicklung von Systemen, die den zunehmend wichtigen ethischen Standards entsprechen.

Warum Entwickler sich dafür entscheiden

Das Cohere SDK hat vor allem deshalb an Popularität gewonnen, weil es die Hürde für die Implementierung anspruchsvoller NLP-Funktionen deutlich senkt. Entwickler ohne Machine-Learning-Expertise können Anwendungen mit minimalem Code um fortgeschrittenes Sprachverständnis erweitern und behalten gleichzeitig bei Bedarf die detaillierte Kontrolle über das Modellverhalten.

Der API-First-Ansatz bedeutet außerdem, dass sich Teams nicht um das Infrastrukturmanagement oder den neuesten Forschungsstand kümmern müssen – Cohere übernimmt diese Aspekte, sodass sich Entwickler auf ihre Anwendungslogik konzentrieren können.

Ideale Anwendungsfälle

Das Cohere SDK eignet sich hervorragend für:

Startups und Teams ohne dedizierte ML-Infrastruktur

Anwendungen, die schnell skaliert werden müssen, ohne die Modellbereitstellung verwalten zu müssen

Projekte, die Zuverlässigkeit und Support auf Unternehmensniveau erfordern

Mehrsprachige Anwendungen für globale Märkte

Anwendungsfälle, bei denen verantwortungsvolle KI-Praktiken Priorität haben

Überlegungen

Der größte Nachteil von Cohere besteht darin, dass Entwickler auf einen Drittanbieterdienst angewiesen sind, anstatt Modelle in ihrer eigenen Infrastruktur auszuführen. Dies führt zu potenziellen Bedenken hinsichtlich Datenschutz, Serviceverfügbarkeit und langfristiger Preisstabilität. Einige Entwickler weisen außerdem darauf hin, dass der API-basierte Ansatz zwar praktisch ist, aber im Vergleich zum direkten Zugriff auf die internen Modellkomponenten manchmal die Flexibilität einschränkt.

4. PyTorch NLP (Torchtext 3.0): Die Wahl des Forschers

Wichtige Funktionen und Verbesserungen

Die neueste Version bietet mehrere wichtige Neuerungen:

Native Unterstützung für Transformer-Architekturen: Erstklassige Implementierungen von Aufmerksamkeitsmechanismen und Transformer-Blöcken erleichtern die Implementierung benutzerdefinierter Architekturen.

Optimierte Datenverarbeitungs-Pipelines: Neue vektorisierte Textverarbeitungsvorgänge nutzen moderne CPUs und GPUs effektiver und beschleunigen die Vorverarbeitungsschritte erheblich.

Verbessertes Transfer-Learning-Framework: Die optimierte API erleichtert die Anpassung vortrainierter Modelle an neue Aufgaben und behält gleichzeitig die präzise Kontrolle über den Trainingsprozess.

Quantisierungs- und Pruning-Tools: Integrierte Funktionen zur Modellkomprimierung ermöglichen es Forschern, Modellgröße und Inferenzzeit ohne übermäßige Leistungseinbußen zu reduzieren.

Verbesserte Batchverarbeitung: Intelligentere Batch-Strategien für Sequenzen variabler Länge führen zu einer effizienteren GPU-Auslastung während des Trainings.

Warum sich Forscher und Entwickler dafür entscheiden

PyTorch NLP ist nach wie vor die bevorzugte Wahl für Forschung und spezialisierte Anwendungen, da es maximale Flexibilität ohne Einbußen bei der Benutzerfreundlichkeit bietet. Der imperative Programmierstil entspricht der Denkweise der meisten Entwickler und erleichtert das Debuggen von Modellen und das Experimentieren mit neuen Ansätzen.

Die nahtlose Integration in das breitere PyTorch-Ökosystem bedeutet zudem, dass Fortschritte im allgemeinen Deep Learning (wie Optimierungstechniken oder Trainingsmethoden) unmittelbar auf NLP-Aufgaben anwendbar sind.

Ideale Anwendungsfälle

PyTorch NLP eignet sich am besten für:

Forschungsprojekte zur Erforschung neuartiger Architekturen oder Trainingsansätze

Anwendungen, die ein individuelles Modellverhalten erfordern, das in übergeordneten Bibliotheken nicht verfügbar ist

Bildungskontexte, in denen die Kenntnis der internen Modellfunktionen wichtig ist

Projekte, die die Integration mit Computer Vision oder anderen Modalitäten erfordern

Situationen, die maximale Kontrolle über den Trainingsprozess erfordern

Hinweise

Die Flexibilität von PyTorch NLP geht mit einer höheren Lernkurve und mehr Implementierungsverantwortung einher. Entwickler müssen im Vergleich zu übergeordneten Bibliotheken mehr Architekturentscheidungen treffen und mehr Komponenten von Grund auf neu implementieren. Darüber hinaus erfordern einige Funktionen zur Produktionsoptimierung zusätzlichen Aufwand für die ordnungsgemäße Implementierung.

Testen Sie IHR Unternehmen in Minuten

Erstellen Sie Ihr Konto und starten Sie Ihren KI-Chatbot in wenigen Minuten. Vollständig anpassbar, keine Programmierung erforderlich - beginnen Sie sofort, Ihre Kunden zu begeistern!

5. JAX NLP (FLAX/Prax): Leistung im großen Maßstab

Wichtige Funktionen und Verbesserungen

Das NLP-Ökosystem von JAX bietet mehrere entscheidende Vorteile:

Transparente XLA-Kompilierung: Automatische Optimierung für TPUs, GPUs und Spezialhardware sorgt für deutliche Verbesserungen der Trainings- und Inferenzgeschwindigkeit.

Funktionales Programmiermodell: Der rein funktionale Ansatz vereinfacht die Verteilung auf mehrere Geräte und hilft, subtile Trainingsfehler zu vermeiden.

Erweiterte Parallelität: Integrierte Unterstützung für Modell-, Daten- und Pipeline-Parallelität macht das Training umfangreicher Modelle einfacher.

Hardwarespezifische Optimierungen: Spezialisierte Implementierungen nutzen die neuesten Beschleunigerfunktionen verschiedener Hardwareanbieter voll aus.

Integration von Differential Privacy: Integrierte Unterstützung für private Trainingsmethoden erfüllt die wachsenden regulatorischen Anforderungen im Bereich Datenschutz.

Warum Teams sich dafür entscheiden

Unternehmen, die mit extrem großen Modellen oder Datensätzen arbeiten, entscheiden sich vor allem wegen der Performancevorteile für JAX-basierte Lösungen. Modelle, deren Training auf anderen Frameworks Wochen dauern würde, können mit JAX oft innerhalb weniger Tage fertiggestellt werden, was erhebliche Kosteneinsparungen bei den Cloud-Rechenressourcen bedeutet.

Der funktionale Ansatz bietet zudem Vorteile hinsichtlich Reproduzierbarkeit und Debugging, die mit zunehmender Komplexität der Modelle und steigenden Trainingskosten immer wichtiger werden.

Ideale Anwendungsfälle

JAX NLP ist ideal für:

Training und Bereitstellung sehr großer Sprachmodelle

Unternehmen mit Zugriff auf spezialisierte Hardware (TPUs etc.)

Projekte, die maximale Rechenleistung erfordern

Situationen, in denen Reproduzierbarkeit entscheidend ist

Anwendungen, die strenge Datenschutzgarantien erfordern

Überlegungen

Das Programmiermodell von JAX ist zwar leistungsstark, unterscheidet sich aber deutlich von den bekannteren objektorientierten Ansätzen anderer Frameworks. Dies kann den anfänglichen Lernaufwand erhöhen, insbesondere für Entwickler ohne fundierte Kenntnisse in funktionaler Programmierung. Darüber hinaus verfügt das Ökosystem zwar schnell über mehr als etablierte Frameworks, verfügt aber noch immer über weniger einsatzbereite Komponenten.

6. TensorFlow Text 3.0: Unternehmensstabilität

Wichtige Funktionen und Verbesserungen

TensorFlow Text 3.0 bietet mehrere wichtige Erweiterungen:

Integration mit TF Extended: Die nahtlose Anbindung an die Produktions-ML-Pipeline-Tools von TensorFlow vereinfacht den Weg vom Experiment bis zur Bereitstellung.

Verbesserte TFLite-Unterstützung: Verbesserte Textverarbeitungsvorgänge in TFLite machen die Bereitstellung von NLP-Modellen auf mobilen und Edge-Geräten einfacher.

Konsistente plattformübergreifende Erfahrung: Dieselben Modelle und Verarbeitungspipelines funktionieren zuverlässig in allen Trainings- und Inferenzumgebungen, von Cloud-TPUs bis hin zu mobilen Geräten.

Erweiterte Unternehmensintegration: Native Konnektoren für gängige Unternehmensdatenquellen vereinfachen die Integration der Textverarbeitung in bestehende Workflows.

Umfassende Bereitstellungsoptionen: Von TF Serving über SavedModel bis hin zu TFLite decken die Bereitstellungsoptionen praktisch jede Zielumgebung ab.

Warum Unternehmen sich dafür entscheiden

TensorFlow Text erfreut sich in Unternehmensumgebungen weiterhin großer Beliebtheit, da es eine Komplettlösung von der Datenaufbereitung bis zur Bereitstellung bietet. Die Stabilität der API und die umfangreichen Bereitstellungsoptionen reduzieren das Risiko der Integration von NLP in unternehmenskritische Anwendungen.

Die Integration mit den Cloud-Angeboten von Google ermöglicht zudem eine unkomplizierte Skalierung für Unternehmen, die bereits in dieses Ökosystem investiert haben.

Ideale Anwendungsfälle

TensorFlow Text 3.0 eignet sich hervorragend für:

Unternehmensanwendungen, die Produktionsstabilität erfordern

Mobile und Edge-Bereitstellungsszenarien

Unternehmen mit bestehenden TensorFlow-Investitionen

Projekte, die umfassende ML-Pipelines benötigen

Anwendungen, bei denen Bereitstellungsflexibilität unerlässlich ist

Hinweise

TensorFlow Text erweitert zwar kontinuierlich neue Funktionen, hinkt aber bei der Umsetzung neuester Forschungsergebnisse manchmal anderen Frameworks hinterher. Zudem empfinden einige Entwickler das symbolische Programmiermodell im Vergleich zum imperativen Ansatz von PyTorch als weniger intuitiv für Experimente.

7. Flair 2.0: Das NLP-Schweizer Taschenmesser

Wichtige Funktionen und Verbesserungen

Flair 2.0 bietet mehrere wichtige Verbesserungen:

Hybrid Embeddings Framework: Kombinieren Sie einfach verschiedene Embedding-Typen (kontextuell, statisch, auf Zeichenebene), um optimale Leistung für spezifische Aufgaben zu erzielen.

One-Shot-Learning-Funktionen: Neue Few-Shot-Learning-Techniken liefern überraschend gute Ergebnisse bei spezialisierten Aufgaben mit minimal gelabelten Daten.

Verbesserte Dokumentenintelligenz: Verbesserte Ansätze zur Dokumentmodellierung erfassen langfristige Abhängigkeiten in langen Texten besser.

Optimierte Feinabstimmung: Vereinfachte Workflows zur Anpassung vortrainierter Modelle an spezifische Domänen oder Aufgaben.

Geringere Ressourcenanforderungen: Dank der verbesserten Effizienz eignet sich Flair auch für den Einsatz auf weniger leistungsstarker Hardware.

Warum Entwickler sich dafür entscheiden

Flair hat eine treue Anhängerschaft gewonnen, weil es ein hervorragendes Gleichgewicht zwischen Leistung und Einfachheit bietet. Die Bibliothek bietet nahezu modernste Leistung für viele gängige NLP-Aufgaben und benötigt dabei deutlich weniger Code und Rechenressourcen als schwerere Frameworks.

Das intuitive API-Design macht Flair auch für Entwickler zugänglich, die keine NLP-Spezialisten sind, sodass sie anspruchsvolles Sprachverständnis mit relativ geringer Lernkurve in ihre Anwendungen integrieren können.

Ideale Anwendungsfälle

Flair 2.0 eignet sich am besten für:

Projekte, die exzellente Sequenzkennzeichnung (NER, POS-Tagging) erfordern

Anwendungen mit begrenzten Rechenressourcen

Teams, die eine schnelle Implementierung von Standard-NLP-Aufgaben anstreben

Szenarien mit minimal gekennzeichneten Trainingsdaten

Spezialisierte Textklassifizierungsanwendungen

Hinweise

Obwohl Flair seine Fähigkeiten kontinuierlich erweitert, bietet es nicht die gleiche Bandbreite an Modellen und Techniken wie größere Frameworks wie Hugging Face Transformers. Darüber hinaus weisen einige Entwickler darauf hin, dass die Dokumentation zwar verbessert wurde, es ihr aber immer noch an den umfassenden Beispielen mangelt, die in etablierteren Bibliotheken zu finden sind.

Fazit: Die richtige NLP-Bibliothek für Ihre Bedürfnisse auswählen

Hugging Face Transformers 6.0 bietet das umfassendste Ökosystem und die umfassendste Modellauswahl.

SpaCy 4.0 bietet industrietaugliche Leistung und Produktionszuverlässigkeit.

Cohere SDK bietet API-First-Komfort mit kontinuierlich aktualisierten Modellen.

PyTorch NLP bietet Forschern maximale Flexibilität und Kontrolle.

JAX NLP bietet unübertroffene Leistung für groß angelegte Anwendungen.

TensorFlow Text 3.0 bietet unternehmensweite Stabilität und Bereitstellungsoptionen.

Flair 2.0 vereint beeindruckende Funktionen in einem schlanken Paket.

Die richtige Wahl hängt von Ihren spezifischen Anforderungen ab:

Für schnelles Prototyping und den Zugriff auf modernste Modelle ist Hugging Face Transformers nach wie vor unschlagbar. Wenn Produktionszuverlässigkeit und -effizienz Ihre Hauptanliegen sind, ist SpaCy weiterhin die beste Wahl. Wenn Entwicklungsgeschwindigkeit und einfache Implementierung im Vordergrund stehen, bietet der API-First-Ansatz von Cohere überzeugende Vorteile.

Forscher, die maximale Flexibilität benötigen, werden weiterhin PyTorch NLP bevorzugen, während Organisationen, die umfangreiche Modelle trainieren, von den Performance-Optimierungen von JAX profitieren. Unternehmen, die Wert auf Stabilität und umfassende Bereitstellungsoptionen legen, finden in TensorFlow Text eine sichere Wahl, und Teams, die eine schlanke Lösung mit beeindruckenden Funktionen suchen, sollten Flair in Betracht ziehen.

Da sich die NLP-Technologie rasant weiterentwickelt, hilft Ihnen die ständige Information über die Funktionen und Entwicklungstrends dieser Bibliotheken, die beste Wahl für Ihre Projekte zu treffen und Ihre Anwendungen auf dem neuesten Stand zu halten.

Was ist Ihr nächstes NLP-Projekt und welche dieser Bibliotheken könnte perfekt zu Ihren spezifischen Anforderungen passen?